Künstliche Intelligenz im eigenen Unternehmens-Netzwerk aufbauen

Willkommen zu Ihrem ultimativen Leitfaden, um Künstliche Intelligenz (KI) direkt in Ihrem eigenen Büro und Unternehmensnetzwerk zu integrieren. In einer Zeit, in der KI und maschinelles Lernen nicht nur die Technologiewelt, sondern auch viele andere Branchen revolutionieren, wird es immer wichtiger, diese Fähigkeiten direkt in Ihrem Unternehmen zu nutzen. Doch wie beginnt man diesen Prozess? Welche Hardware wird benötigt, und wie installiert man die notwendige Software?

In diesem Artikel zeigen wir Ihnen nicht nur, welche Hardware-Komponenten Sie benötigen, sondern auch wie eine Komplett-Lösung für Sie aussehen kann um Ihre eigene KI-Infrastruktur aufzubauen. Die Zusammenstellung übernehmen wir für unsere Kunden. Die Installation der erforderlichen Software erfolgt auf einem Ubuntu Server. Mit diesem Angebot machen wir den Einstieg in die Welt der Künstlichen Intelligenz für Ihr Unternehmen einfach und verständlich.

Unser Ziel ist es, Ihnen nicht nur die notwendigen Werkzeuge an die Hand zu geben, sondern Sie auch auf Ihrem Weg zu unterstützen. Aus diesem Grund bieten wir zusätzlich maßgeschneiderte Consulting-Dienstleistungen und Schulungen an. Egal, ob Sie Ihr Team fit für die Zukunft machen möchten oder spezifische Anwendungsfälle für Ihr Unternehmen entwickeln wollen – wir stehen Ihnen zur Seite.

Bereiten Sie sich darauf vor, Ihre Geschäftsprozesse zu optimieren, innovative Lösungen zu entwickeln und durch den Einsatz von Künstlicher Intelligenz neue Möglichkeiten zu entdecken. Lesen Sie weiter und starten Sie noch heute mit der Implementierung Ihrer eigenen KI-Lösung.

Hier sehen Sie ein Beispiel für eine Hardware Aussstattung :

| Hardware | Bemerkung |

|---|---|

| ASUS ROG Strix Z790-E Gaming | Motherboard |

| Intel Core i9-13900K | Prozessor |

| 64 GB DDR5-5200 | RAM Speicher |

| 850W 80+ Gold | Netzteil |

| 2 TB NVMe SSD | SSD-Speicher |

| NVIDIA GeForce RTX 4080 (16 GB) | Grafikkarte |

Diese Ausstattung ist mit einem INTEL Core i9 Prozessor. Es gibt eine weitere Konfiguration mit einem AMD Ryzen als Prozessor.

| Hardware | Bemerkung |

|---|---|

| ASUS ROG Crosshair X670E Extreme | Motherboard |

| AMD Ryzen 9 7950X | Prozessor |

| 64 GB DDR5-5200 CL38 | RAM Speicher |

| 850W 80+ Gold | Netzteil |

| 2 TB NVMe SSD | SSD-Speicher |

| NVIDIA GeForce RTX 4080 (16 GB) | Grafikkarte |

| Fractal Design Define 7 | Gehäuse |

Die Nutzung einer eigenen KI birgt viele spannende Möglichkeiten, aber auch einige Aspekte, die es zu beachten gilt. Lassen Sie uns diese Punkte genauer beleuchten:

Größe der Sprachmodelle:

- Speicherbedarf: Größere Modelle benötigen mehr Speicherplatz, sowohl auf der Festplatte als auch im Arbeitsspeicher.

- Rechenleistung: Das Training und der Betrieb großer Modelle erfordern leistungsstarke Hardware, insbesondere GPUs.

- Leistungsfähigkeit: Größere Modelle sind in der Regel in der Lage, komplexere Aufgaben zu lösen und liefern oft bessere Ergebnisse.

- Trainingszeit: Das Training großer Modelle kann sehr zeitaufwendig sein.

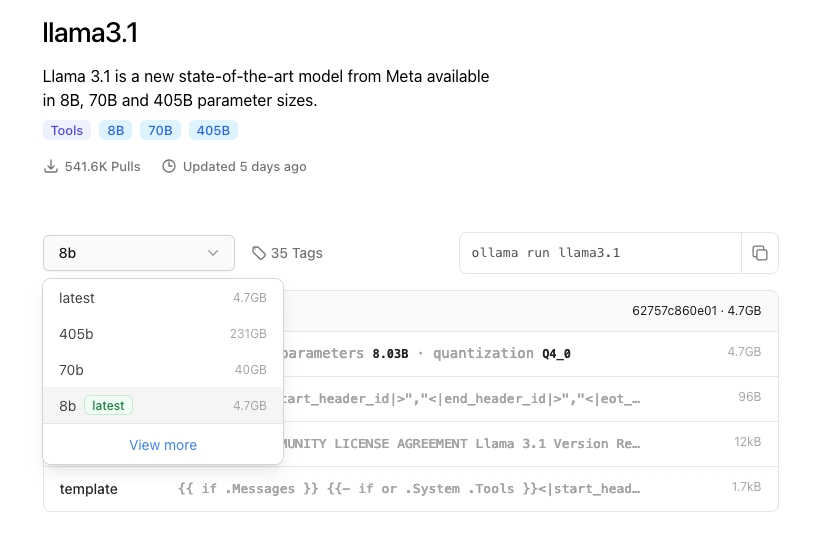

Llama 3.1 ist ein beeindruckendes Sprachmodell, das von Meta AI entwickelt wurde. Es gibt dieses Modell in verschiedenen Größen, nämlich 7B, 13B, 33B, 65B und 405B Parameter. Diese Zahlen beziehen sich auf die Anzahl der "verknüpfbaren Parameter" im Modell, die es ihm ermöglichen, komplexe Muster in Daten zu erkennen und zu generieren.

Was bedeuten diese unterschiedlichen Größen?

- 7B, 13B, 33B, 65B und 405B: Diese Zahlen stehen für die Milliarden Parameter, die das Modell hat.

- Größere Modelle: Je größer das Modell, desto mehr Daten kann es verarbeiten und desto komplexere Aufgaben kann es lösen. Ein 405B-Parameter-Modell ist beispielsweise in der Lage, viel nuanciertere und komplexere Texte zu generieren als ein 7B-Modell.

- Kompromisse: Größere Modelle erfordern mehr Rechenleistung und Speicherplatz. Sie sind also auch ressourcenintensiver.

Was sind die Vorteile der größeren Modelle?

- Bessere Leistung: Größere Modelle können in der Regel komplexere Aufgaben besser lösen, wie z.B. das Übersetzen von Sprachen, das Schreiben von Code oder das Verfassen kreativer Texte.

- Flexibilität: Sie können für eine Vielzahl von Anwendungen eingesetzt werden und sind oft besser anpassbar an spezifische Aufgaben.

Was sind die Nachteile der größeren Modelle?

- Höherer Ressourcenbedarf: Größere Modelle benötigen mehr Rechenleistung und Speicherplatz.

- Längere Trainingszeiten: Das Trainieren großer Modelle kann sehr zeitaufwendig sein.

- Komplexität: Größere Modelle sind komplexer und können schwieriger zu verstehen und zu kontrollieren sein.

Die Wahl der richtigen Modellgröße hängt von der spezifischen Anwendung ab. Wenn Sie eine einfache Aufgabe lösen möchten, wie z.B. das Generieren von kurzen Texten, kann ein kleineres Modell ausreichen. Für komplexere Aufgaben, wie z.B. das Erstellen von langen und kohärenten Texten oder das Übersetzen von Fachtexten, ist ein größeres Modell besser geeignet.

Wichtiger Hinweis:

Die Nutzung von großen Sprachmodellen wirft auch ethische Fragen auf, wie z.B. die Gefahr von Verzerrungen oder die Möglichkeit von Missbrauch. Es ist wichtig, sich dieser Herausforderungen bewusst zu sein und verantwortungsvoll mit diesen Modellen umzugehen.

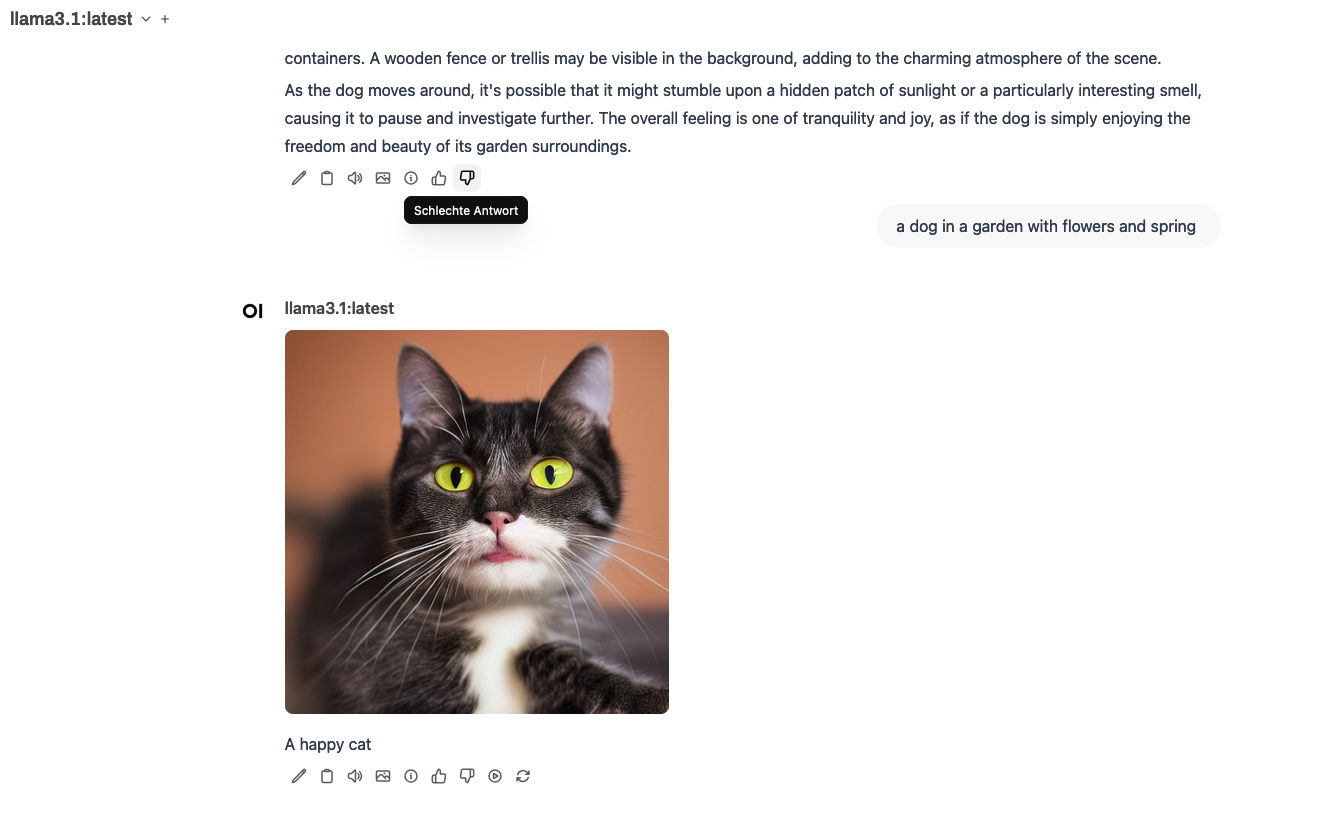

Erstellen von Bildern mit Stable Diffusion oder Fooocus:

- Datengrundlage: Die Qualität der erzeugten Bilder hängt stark von der Qualität und Vielfalt der Trainingsdaten ab.

- Hyperparameter: Die Einstellung verschiedener Parameter wie Learning Rate, Batch Size oder Anzahl der Epochen kann die Ergebnisse erheblich beeinflussen.

- Hardware: Für das Training und die Nutzung von Stable Diffusion ist eine leistungsstarke GPU erforderlich.

- Kreativität: Die Erstellung von einzigartigen und interessanten Bildern erfordert ein gewisses Maß an Kreativität bei der Auswahl der Prompts und der Einstellung der Parameter.

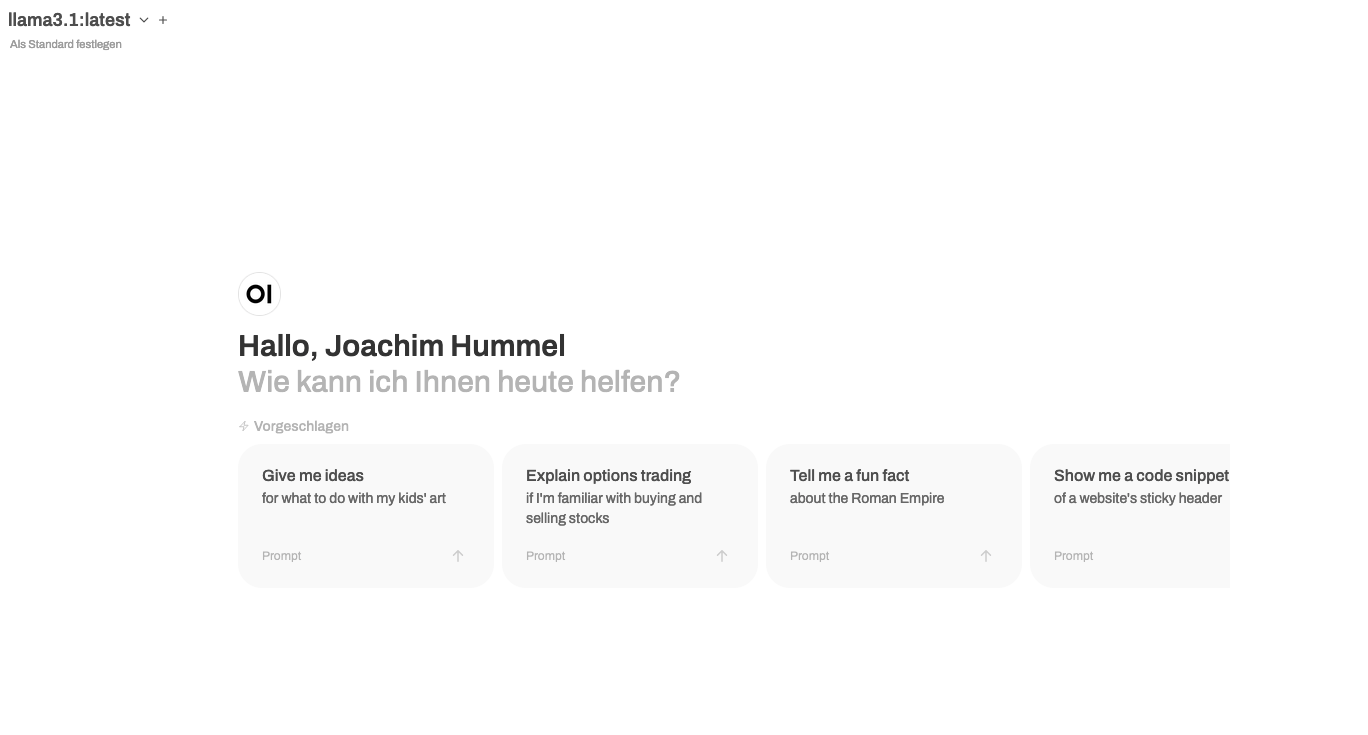

LLM-Modelle von Ollama:

- Modellarchitektur: Die Wahl der Modellarchitektur (z.B. Transformer, RNN) beeinflusst die Leistungsfähigkeit und die Komplexität des Modells.

- Trainingsdaten: Die Qualität und Quantität der Trainingsdaten sind entscheidend für die Sprachfähigkeiten des Modells.

- Feintuning: Durch Feintuning auf spezifische Aufgaben kann die Leistung des Modells für bestimmte Anwendungsfälle verbessert werden.

- Ethische Aspekte: Es ist wichtig, sich der potenziellen Risiken und ethischen Implikationen von Sprachmodellen bewusst zu sein, wie z.B. die Erzeugung von Hassreden oder falschen Informationen.

Weitere wichtige Aspekte:

- Energieverbrauch: Das Training und der Betrieb großer KI-Modelle kann erhebliche Mengen an Energie verbrauchen.

- Datenschutz: Der Umgang mit persönlichen Daten muss sorgfältig geregelt werden, um Datenschutzbestimmungen einzuhalten.

- Bias: KI-Modelle können Verzerrungen enthalten, die in den Trainingsdaten vorhanden sind. Es ist wichtig, diese Verzerrungen zu erkennen und zu reduzieren.

- Kosten: Die Entwicklung und der Betrieb einer eigenen KI kann erhebliche Kosten verursachen, insbesondere für Hardware und Energie.

Zusätzliche Überlegungen:

- Cloud vs. On-Premise: Abhängig von Ihren Anforderungen und Ressourcen können Sie Ihre KI-Modelle in der Cloud oder auf eigenen Servern betreiben.

- Open-Source vs. kommerzielle Lösungen: Es gibt eine Vielzahl von Open-Source- und kommerziellen KI-Frameworks und -Modelle zur Auswahl.

- Community: Der Austausch mit anderen Entwicklern und die Nutzung von bestehenden Communities können Ihnen bei der Entwicklung und dem Einsatz Ihrer KI-Modelle helfen.

Fazit:

Die Entwicklung und der Einsatz einer eigenen KI ist ein komplexes Thema, das viele Aspekte umfasst. Eine sorgfältige Planung und Berücksichtigung der genannten Faktoren ist entscheidend für den Erfolg Ihres Projekts.

Möchten Sie sich tiefer in ein bestimmtes Thema vertiefen? Gerne stehe ich Ihnen für weitere Fragen zur Verfügung.

Hier sind einige konkrete Fragen, die Sie sich stellen könnten:

- Welche Hardware benötige ich für mein Projekt?

- Welche KI-Frameworks sind für meine Anwendung am besten geeignet?

- Wie kann ich meine Modelle vor Verzerrungen schützen?

- Welche rechtlichen Aspekte muss ich beachten?

Lassen Sie uns gemeinsam ihre Fragen beantworten und senden Sie eine Mail für das weitere Vorgehen.

Member discussion